Når og hvis du til efteråret opdaterer din iPhone, iPad, Apple Watch eller Mac til henholdsvis iOS 15, iPadOS 15, watchOS 8 eller macOS Monterey følger der en helt ny funktion med, som Apple har designet for at bekæmpe børneporno og misbrug af børn. Desværre ser det ud til, at prisen for beskyttelsen af børnene bliver et farvel til privatlivets fred.

Teknologien, som Apple annoncerede i går, screener så at sige indholdet på din Apple-enhed for kendte børnepornobilleder. Tilsvarende teknologi er forlængst implementeret hos tjenester som Gmail, Twitter, Facebook og Dropbox, men Apple har indtil nu afvist at tage lignende teknologi i brug, fordi det ville underminere den end-to-end-kryptering og heraf følgende beskyttelse af brugernes data, som hidtil har været et af Apples helt centrale forretningsprincipper.

Men som alle andre vil Apple naturligvis gerne beskytte mindreårige mod misbrug og bekæmpe udbredelsen af børneporno, og derfor har tech-giganten nu udviklet sin egen løsning, som ifølge Apple selv gør det muligt at screene for ulovligt billedmateriale uden at sætte brugernes sikkerhed over styr.

Beskeder, Fotos og Siri

Apples initiativ består af tre separate funktioner.

1) Fotos: Det amerikanske “National Center for Missing and Exploited Children” (NCMEC) vedligeholder en database over kendte børnepornobilleder. Databasen indeholder en såkaldt hashtabel, hvor hvert enkelt billede er blevet tildelt en unik hashværdi, som beregnes baseret på data i det pågældende billede.

Alle eksisterende screening-teknologier, herunder Microsofts PhotoDNA, fungerer ved at den pågældende tjeneste scanner og analyserer alle billeder hos alle brugere. Et billede som er identisk med et billede i børnepornodatabasen består jo af identiske data og vil derfor også få samme hashværdi, hvorefter der er et “hit” i databasens hashtabel.

Hvis man sender en e-mail med et vedhæftet billede til nogen med Gmail eller uploader et billede til Facebook, vil billedfilen således altid først skulle forbi et filter, som beregner billedets hashværdi og sammenligner med databasen for at sikre, at der ikke er tale om børneporno.

Men dén løsning fungerer ikke, hvis den pågældende tjeneste benytter sig af end-to-end-kryptering, for så er det ikke muligt at scanne indholdet. Og derfor har Apple valgt at implementere deres screening-system direkte på brugerens iPhone, iPad, MacBook, etc.

Hashtabellen fra NCMEC’s database bliver fra Apples næste opgradering af sine operativsystemer simpelthen gemt lokalt på brugerens enhed, og alle fotos, der opbevares på enheden og/eller uploades til iCloud vil blive scannet.

På den måde får Apple ikke direkte adgang til brugerens filer, men hvert godkendt billede tildeles en krypteret såkaldt “safety voucher”, og kun hvis et bestemt antal billeder (det præcise antal er ukendt) har givet “hits” i hashtabellen og dermed er blevet identificeret som børneporno, kan Apple åbne op for krypteringen og få adgang til brugerens billeder.

Selvsagt vil Apple så anmelde indehaveren af ulovligt billedmateriale til politiet.

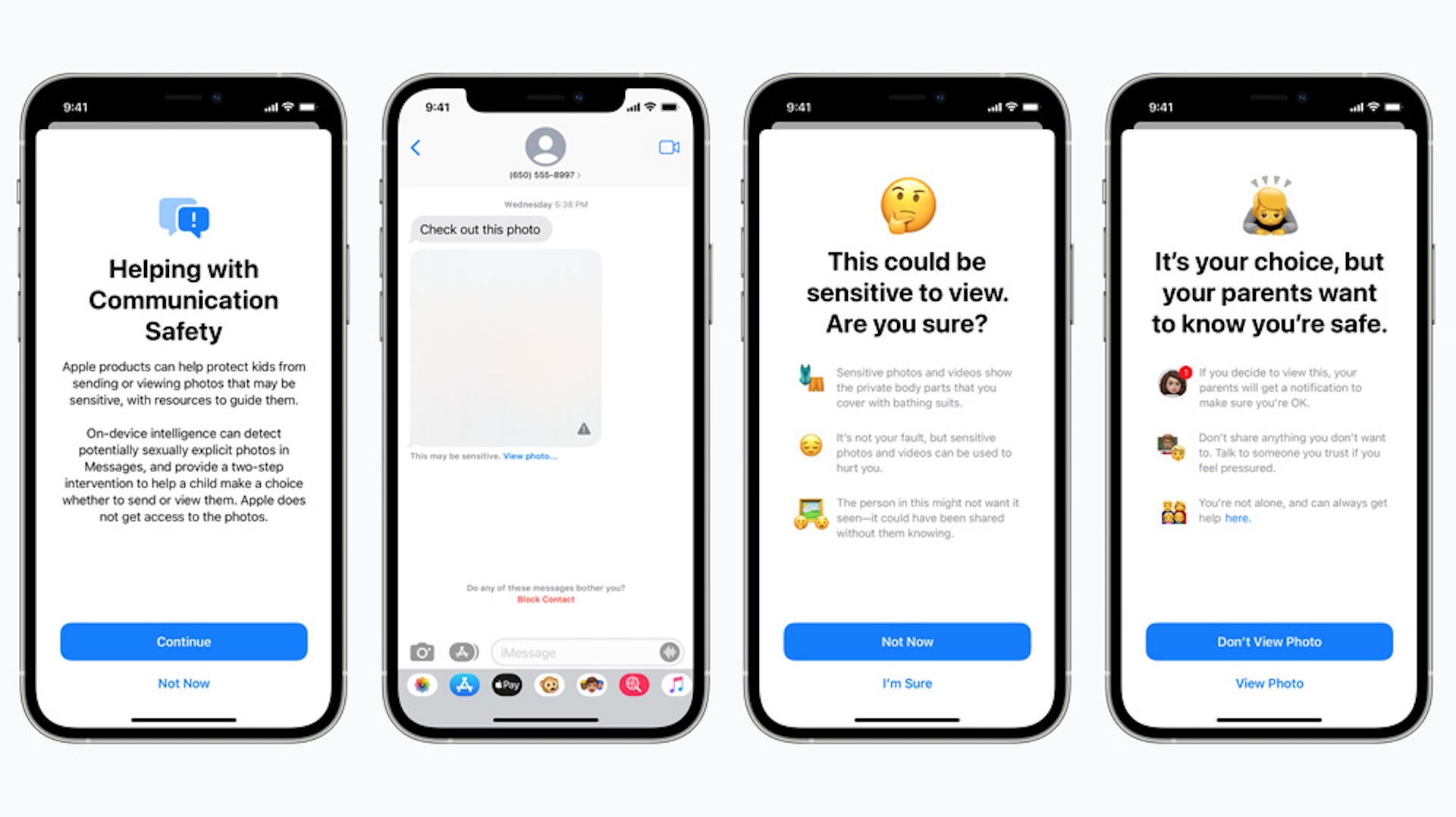

2) Beskeder: Udover konstant at overvåge alle Apple-brugeres enheder for kendt børnepornomateriale vil Apple også forhindre, at mindreårige brugere, kan anvende firmaets egen end-to-end-krypterede chat-app, iMessage (Beskeder på dansk) til at sende eller modtage billeder med seksuelt indhold.

Denne funktion vil i første omgang kun gælde amerikanske brugere, men hensigten er ifølge Apple at gøre beskyttelsen af børn mod seksuelt misbrug global.

Apple forklarer ikke i detaljer, hvordan den nye funktion fungerer rent teknisk. Firmaet skriver blot i et white paper, at iMessage vil blive udvidet med machine learning – altså en slags kunstig intelligens – som fungerer på brugerens enhed og analyserer alle vedhæftede billedfiler for at afgøre, om de er af sexuel karakter eller ej. Funktionen bliver kun aktiveret for mindreårige brugere, der er defineret som sådan i iCloud Familiedeling.

Igen har Apple ikke direkte adgang til beskeder eller billeder, men hvis et vedhæftet billede bliver kategoriseret som anstødeligt, vil det blive sløret, og den mindreåriges forældre vil automatisk få besked, hvis barnet er under 13.

3) Siri: Sidst, men ikke mindst, vil både Siri og Apple-enhedernes indbyggede søgefunktion blive ændret, således at en søgning efter ord som “børneporno” vil udløse en advarsel samt råd om, hvor man kan søge hjælp.

FUCK Apple

FUCK dem 1.000 gange@infosecholsta jeg glæder mig til at se om du stadig kører Apple iPhone på BornHack 😛

— Henrik Kramselund Pfizer 2of2 🏳️🌈 (@kramse) August 6, 2021

Formålet er prisværdigt, men Apples beslutning er en katastrofe

Apple har helt klart anstrengt sig for at kunne udstyre deres enheder med et højt niveau af beskyttelse af børn uden at gå på kompromis med den enkelte brugers sikkerhed.

I modsætning til førnævnte tjenester som Facebook, Google, Dropbox, etc., der overhovedet ikke lægger skjul på, at selvfølgelig har de adgang til alle dine data, har Apple i en årrække lagt stor vægt på, at brugerenes data tilhører dem selv og ikke rager andre. Og da slet ikke Apple.

Og rent teknisk virker Apples løsning elegant, for firmaet får virkelig først adgang til dine billeder og andre data, hvis der er adskillige træffere i databasen over kendte børneporno-billeder, og så vidt angår nøgenbilleder eller seksuelt eksplicitte billeder i chats, hvor mindst én deltager er mindreårig, er det kun barnets forældre, der får besked.

Men efter min bedste overbevisning er Apples nye tiltag i virkeligheden en katastrofe for privatlivets fred. Og det siger jeg ikke, fordi jeg på nogen måde ønsker at forhindre, at børn beskyttes mod misbrug. Det siger jeg, fordi Apples løsning på nogle måder faktisk er langt mere indgribende end de løsninger, som f.eks. Google, Facebook og Dropbox gør brug af. Og dermed har Apple åbnet en ladeport på vid gab for systematisk undergravelse af datasikkerhed og brugernes ret til at bestemme, hvem der har adgang til deres data.

Apple plans to modify iPhones to constantly scan for contraband:

“It is an absolutely appalling idea, because it is going to lead to distributed bulk surveillance of our phones and laptops,” said Ross Anderson, professor of security engineering. https://t.co/rS92HR3pUZ

— Edward Snowden (@Snowden) August 5, 2021

En glidebane

Det afgørende her er, at Apple med den nye teknologi i praksis har bygget en velfungerende bagdør ind i alle deres brugeres fysiske enheder.

I og med at teknologien – sågar i privatlivets hellige navn – ikke blot koncentrerer sig om de data, du måtte vælge at sende til andre eller placere i skyen via internettet, men faktisk fungerer lokalt på din egen enhed, har Apple i princippet skaffet sig adgang til ALLE dine data. Alt du har liggende på din mobil, tablet eller computer i hvert fald. Hvorsomhelst og nårsomhelst.

Og at det sker i en god sags tjenester forhindrer ikke såkaldt mission creep, hvor en teknologi, der i første omgang bliver implementeret med ét bestemt formål, som alle kan blive enige om at støtte, med tiden kan blive udvidet til at blive anvendt til andre formål.

Apples produkter sælges over hele verden. Også i lande som Kina, hvor Apple under pres fra den kinesiske regering allerede har slækket på sine egne principper og opbevaret følsomme kundedata fra kinesiske brugere på servere i et datacenter under kontrol af den kinesiske regering. Ligesom virksomheden også har fjernet f.eks. VPN-apps fra App Store, fordi de kinesiske myndigheder forlangte det.

Der skal ikke meget fantasi til at forestille sig, at den teknologi, Apple nu gør til en integreret del af alle sine operativsystemer kan misbruges af regeringer, der f.eks. ønsker at lede efter brugere, der har billeder af ulovlige politiske slogans på deres mobiltelefon. Et meget realistisk scenarie f.eks. i Hong Kong.

Et filter, som leder efter seksuelt eksplicitte billeder af mindreårige, kan lidt for nemt justeres, så det kan indsættes i jagten på homoseksuelle i det ret store antal lande, hvor homoseksualitet stadig er strafbart.

Og så videre, og så videre.

Hvis du ikke tror på, at Apple nogensinde vil tillade, at deres teknologi bliver misbrugt, minder jeg igen om, hvordan Apple hjælper den kinesiske regering med at udøve censur og giver de kinesiske myndigheder adgang til data om politisk forfulgte kinesiske borgere.

Just to state: Apple’s scanning does not detect photos of child abuse. It detects a list of known banned images added to a database, which are initially child abuse imagery found circulating elsewhere. What images are added over time is arbitrary. It doesn’t know what a child is.

— SoS (@SwiftOnSecurity) August 5, 2021

Falsk markedsføring

At Apple givetvis vil blive ved med at markedsføre sine produkter og tjenester som end-to-end-krypterede, mens firmaet reelt har integreret et sofistikeret og effektivt overvågningssystem i alle sine produkter, gør mig ikke mildere stemt.

Specielt ikke, fordi Apple på hyklerisk vis forsøger at vække en tillid hos deres brugere, som de i stik modsætning til, hvad de siger, reelt underminerer voldsomt ved at indbygge overvågningssoftware på systemniveau i alle brugernes enheder. Jeg mener, stoler du virkelig SÅ meget på Apple, at du finder det i orden, at din mobil eller computer bliver udstyret med teknologi, der kan analysere alle dine billeder?

Heller ikke en teknologi, der er udviklet i en god sags tjeneste kan retfærdiggøre, at brugernes ret til privatliv bliver undergravet.